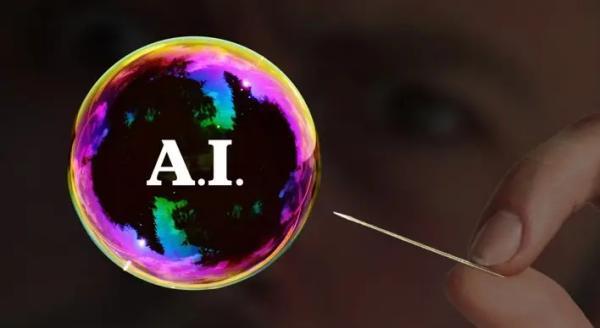

آیا حباب هوش مصنوعی در آستانه ترکیدن است؟ نگاهی واقع بینانه به مدل های زبانی بزرگ

به گزارش مجله اینمن، این روزها خبرهایی از گوشه و کنار می رسد که آینده مدل های زبانی بزرگ مثل چت بات ها چندان روشن نیست. گَری مارکِس (Gary Marcus)، یکی از منتقدان مشهور حوزه هوش مصنوعی، بار دیگر به این موضوع پرداخته و هشدار داده که ارزش گذاری های فوق العاده بالای این فناوری ها ممکن است بیشتر یک حباب باشد که به زودی می ترکد. شرکت هایی مثل اوپن ای آی (OpenAI) و مایکروسافت به علت انتظاراتی که از مدل های زبانی بزرگ دارند، ارزش گذاری های بالایی دارند. تصور می گردد که این مدل ها با توسعه و توسعه به هوش مصنوعی عمومی (AGI) تبدیل خواهند شد؛ اما مارکِس معتقد است این تصور خیلی خوش بینانه است و پایه ای در واقعیت ندارد.

مارکِس شرح می دهد که مدل های زبانی بزرگ در اصل فقط بر اساس آمار زبان کار می نمایند و نمی توانند واقعیت را درک نمایند. این باعث می گردد که گاهی اوقات اطلاعات نادرست یا حتی عجیبی ارائه دهند، که اصطلاحاً به آن توهم (Hallucination) گفته می گردد. این مشکل صرفاً با افزایش قدرت پردازشی و توسعه سخت افزار حل نمی گردد؛ چراکه ریشه در نحوه عملکرد این مدل ها دارد، و آن ها اساساً نمی توانند فرایندهای فکری و منطقی انسانی را شبیه سازی نمایند.

اقتصاد سخت مدل های زبانی بزرگ

از سوی دیگر، مارکِس به مسائل مالی این مدل ها نیز اشاره می نماید. هزینه های آموزش و توسعه این مدل ها به حدی بالاست که برای بسیاری از شرکت ها صرفه مالی ندارد. با افزایش مقیاس، هزینه ها هم افزایش می یابد، و ممکن است در نهایت این مدل ها به سطحی برسند که دیگر سودآور نباشند. به همین علت، محتمل است که این فناوری به زودی به یک محصول عمومی تبدیل گردد که شرکت ها مجبور شوند با کاهش قیمت، مشتری جذب نمایند، و همین مسئله می تواند سوددهی را کاهش دهد.

مارکِس حتی پیش بینی می نماید که شرکت هایی مثل ان ویدیا (NVidia)، که تولیدنماینده تراشه های قدرتمند برای هوش مصنوعی هستند، هم ممکن است با کاهش ارزش روبرو شوند، زیرا ارزش فعلی شان بر اساس انتظاراتی است که ممکن است واقعی نباشند.

آیا ماشین ها می توانند شبیه انسان فکر نمایند؟

سؤال اساسی اینجاست: شاید علت این که نمی توانیم مشکل توهمات را در مدل های هوش مصنوعی حل کنیم این باشد که اساساً امکان شبیه سازی فکر انسان وجود ندارد. مارکِس و دیگر منتقدان بر این باورند که مدل های زبانی بزرگ، به علت روش ساختار و پردازش اطلاعات، هرگز نمی توانند به سطحی از فهم و درک واقعی برسند و تنها قادر به بازتولید جملاتی هستند که آماری درست به نظر می رسند.

پیامدهای این چالش در دنیای واقعی

در عمل، بسیاری از شرکت ها که برای کاهش هزینه ها به هوش مصنوعی روی آورده اند و نویسندگان و ویراستاران انسانی را کنار گذاشته اند، اکنون با مسائل جدی روبرو هستند. این شرکت ها دریافته اند که خلاقیت، منطق و قضاوت انسانی را نمی توان در ماشین ها به سادگی جایگزین کرد. بدون ورودی مداوم از سوی انسان ها، کیفیت خروجی مدل های زبانی بزرگ به مرور زمان کاهش می یابد؛ اتفاقی که به فروپاشی مدل معروف است. این چالش ها نشان می دهند که اگرچه هوش مصنوعی می تواند ابزاری قدرتمند باشد، اما هنوز به تعامل و همکاری انسانی وابسته است.

شاید اکنون زمان آن باشد که نگاه واقع بینانه تری به هوش مصنوعی داشته باشیم و انتظاراتمان را منطقی تر کنیم. به نظر می رسد که برای حفظ کیفیت و توسعه بیشتر، به ترکیب هوش مصنوعی و خلاقیت انسانی نیازمندیم، نه جایگزینی کامل.

منبع

mindmattersمنبع: یک پزشک